Dacă privim scara evoluției AI (Inteligenței Artificiale), preocupările lumii juridice față de acest domeniu nu mai intră în categoria aspirațiilor dintr-un SF, ci sunt de foarte mare actualitate și necesitate.

Într-un studiu publicat de către Universitatea Stanford[i], în 2016, se preconizează că până în 2030:

• În domeniul transportului: Vor exista mașini și vehiculele de livrare aeriană;

• În domeniul electrocasnicelor: Vor exista aspiratoare robotice (care deja există în unele case) și roboți specializați în oferirea securității la domiciliu și la locul de muncă;

• În domeniul sănătății: Se vor folosi dispozitivele de monitorizare a sănătății personale pe scară largă, chirurgia asistată de roboți se dezvolt, și vor fi implementate sisteme integrate în domeniul sănătății;

• În domeniul educației: Vor fi tot mai uzitate sistemele interactive de îndrumare care vor ajuta elevii să învețe limbi străine, matematică și alte abilități. Progresele în procesarea limbajului natural sunt susceptibile de a produce noi moduri de a spori instruirea de către oameni;

• În domeniul siguranței și al securității: Camerele foto, dronele și software-ul incorporat în ele vor fi folosite pentru a analiza modelele de criminalitate și pentru a diminua erorile umane și îmbunătățesc siguranța fără pierderea libertății sau a demnității;

• În domeniul ocupării forței de muncă: Multe locuri de muncă vor fi ocupate de către roboți sau dispozitive, oamenii vor fi înlocuiți, dar se vor crea noi tipuri de loc de muncă.

Considerăm că, înainte de orice discuție, este necesară definirea AI: „Sistemele de inteligență artificială (IA) sunt sisteme software (și, eventual, hardware) proiectate de oameni, care, dacă li se dă un obiectiv complex, acționează în dimensiunea fizică sau digitală, percepând mediul prin intermediul preluării datelor, prin interpretarea datelor structurate sau nestructurate colectate, prin raționarea cu privire la cunoștințe sau prin prelucrarea informațiilor obținute din aceste date și prin deciderea celei/celor mai bune acțiuni care trebuie întreprinse pentru a realiza obiectivul dat. Sistemele IA pot fie să utilizeze reguli simbolice, sau să învețe un model numeric și, de asemenea, își pot adapta comportamentul analizând modul în care mediul este afectat de acțiunile lor anterioare”[ii].

Pentru Uniunea Europeană, piața unică digitală este o prioritate încă din 2010 adoptând numeroase strategii și rapoarte, iar Comisia Europeană, a adoptat în 19.02.2020 o carte albă[iii] în materie de inteligența artificială prin care statutează faptul că dezvoltarea Europei se va baza pe valoarea creată de date, iar Inteligența Artificială este una din principalele componente a aceste dezvoltări. Astfel, vom regăsi tehnologii distruptive bazate pe AI în tot mai multe domenii și va fi la îndemâna oricui să le folosească.

Prin urmare, chiar dacă nu putem privi mai departe de un anumit punct, pe care noi îl numim „unghiul mort al AI”, având în vedere că dreptul nu este altceva decât transpunerea vieții în norme de conduită, că se bazează tot pe fundamentul „if (…) then (…)” ca într-un limbaj de programare, o condiționare pentru o funcționare optimă a sistemului reprezentat de societate, atunci evoluția legislativă trebuie să țină pasul cu evoluția tehnicii. În acest sens, considerăm necesară abordarea răspunderii Inteligenței Artificiale din punct de vedere juridic.

A. Din perspectiva dreptului civil

În momentul de față, persoanele considerate a fi responsabile în cazul producerii unei infracțiuni sunt producătorul sau utilizatorul. Dar discuția care încă subzistă privește răspunderea Inteligenței Artificiale dezvoltată prin cod open source la care contribuie un număr necunoscut de persoane și nu pot fi identificate. În plus, situația devine mai complicată când dispozitivul bazat pe AI devine conștient de sine, capabil de autoperfecționare etc.

Într-adevăr, doctrina și jurisprudența percepe lucrurile create de om fiind în imposibilitate de răspundere, astfel, răspunderea pentru prejudiciile cauzate de lucruri este prevăzută de art. 1376 C. civ..: „Oricine este obligat să repare, independent de orice culpă, prejudiciul cauzat de lucrul aflat sub paza sa”. În absența unei definiții legale, interpretarea noțiunii de lucru poate fi desprinsă din dispozițiile art. 535 noul C. civ., ca fiind acea categorie de bunuri imobile sau mobile care constituie obiectul unui drept patrimonial (de exemplu: undele electromagnetice sau asimilate acestora și energia de orice fel de produse, captate și transmise, precum și lucrurile înglobate într-un imobil cum ar fi un ascensor, o scară rulantă, instalația de canalizare de apă, de electricitate și gaz, o vitrină din sticlă, acoperișul unei clădiri).

Dar, în 2017, Parlamentul European a înaintat un raport care punea în discuție recunoașterea personalității juridice a roboților – ca ”persoane electronice”. Totuși această propunere este foarte controversată[iv].

Raportat la teoria creării unei „ persoane electronice” cea mai cunoscută răspundere a non-persoanelor este răspunderea persoanei juridice. Acestea beneficiază de o serie de drepturi și obligații care îi permit să fie parte într-un raport juridic. În acest sens, în art. 135 alin (1) și (3) C. pen, este reglementată răspunderea persoanei juridice. ”Persoana juridică, cu excepția statului și a autorităților publice, răspunde penal pentru infracțiunile săvârșite în realizarea obiectului de activitate sau în interesul ori în numele persoanei juridice. Răspunderea penală a persoanei juridice nu exclude răspunderea penală a persoanei fizice care a contribuit la săvârșirea aceleiași fapte”.

Oferirea roboților sau AI o personalitate juridică ar putea consta doar din impunerea unor obligații. O astfel de soluție, însă, nu ar fi practic utilă, întrucât răspunderea presupune și impunerea unor sancțiuni restrictive de libertate sau impunerea unor obligații pecuniare pe care acestea nu le-ar putea onora. AI nu are conștiință, spre deosebire de persoanele juridice, AI nu are personalitate juridică și, în lipsa unui patrimoniu propriu și a unui scop, ca expresie a unei conștiințe, nu i-ar putea fi recunoscut statutul de subiect de drept.

Pagubele cauzate de tehnologii chiar autonome este, în general, reductibilă la riscuri atribuibile persoanelor fizice sau persoanelor juridice, cum ar fi utilizatorul sau producătorul/dezvoltatorul. În acest sens, ne raliem la opinia jurisprudențială din domeniu, că, în viitorul apropiat, nu este indicată crearea unei personalități juridice a roboților, ci doar consolidată și armonizată legislația și standardele în domeniu[v].

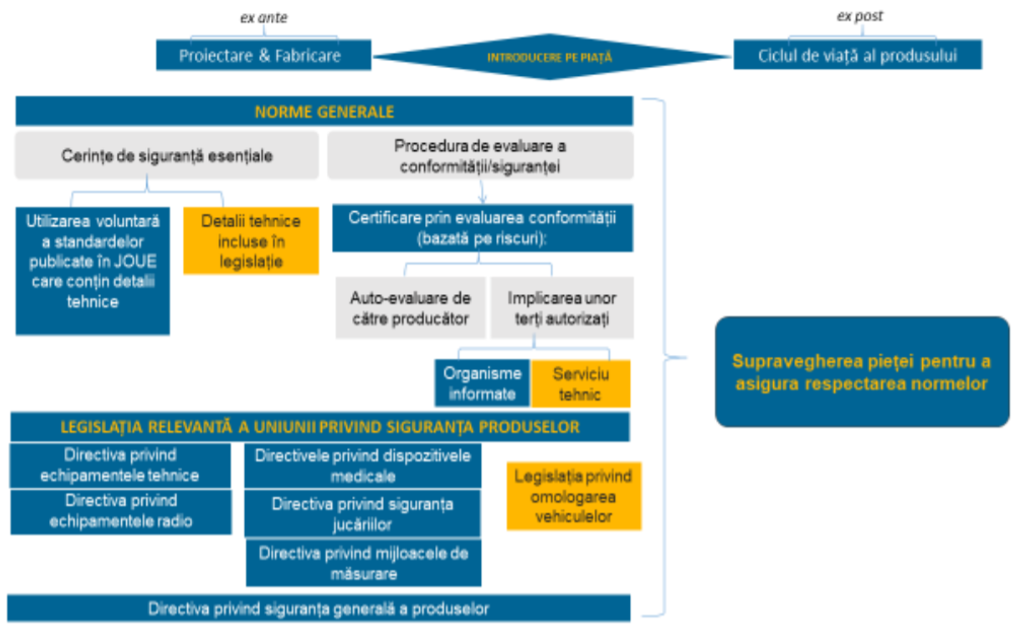

Cadrul legal al Uniunii Europene privind siguranța produselor a fost elaborat, în mare parte, înainte de dezvoltarea tehnologiilor de tipul AI. Astfel, chiar dacă cadrul legislativ nu conține întotdeauna dispoziții care să abordeze în mod explicit provocările și riscurile aferente acestor tehnologii, în materie de siguranță a produselor este absența unor dispoziții explicite nu exonerează aplicarea și asupra produselor care includ aceste tehnologii.

Fig. 1[vi]

În prezent, în România, avem bine reglementată răspunderea civilă delictuală, atât în Codul civil prin art. 1349 și urm., care prevede o răspundere atât subiectivă (pentru fapta proprie), dar și obiectivă (pentru fapta altuia, pentru lucruri).

Totodată, avem diverse forme de răspundere civilă instituite prin Directive ale Uniunii Europene transpuse inclusiv în legislația noastră națională pentru produse fabricate sau comercializate pe teritoriul României. UE a confirmat în Directiva (UE) 2019/771 privind vânzarea de bunuri că vânzătorul este, de asemenea, responsabil pentru astfel de elemente digitale în conformitate cu contractul, inclusiv pentru actualizări oferite pentru o perioadă rezonabilă de timp comunicată consumatorului. Această Directivă are termen de transpunere în legislația națională până în 01.07.2021.

Spre exemplu, în cazul Legii nr. 240/2004 privind răspunderea producătorilor pentru pagubele generate de produsele cu defecte[vii] (numită „product liability law”), producătorul este considerat conform art. 2 alin. 1 lit. a):

„1. fabricantul produsului finit al unei materii prime sau părţi componente ale produsului;

2. orice persoană care se prezintă ca producător, prin faptul că îşi înscrie pe produs numele, marca sau alt semn distinctiv;

3. orice altă persoană, care importă un produs în România în vederea vânzării, închirierii, cumpărării sau altei forme de înstrăinare în cadrul activităţii proprii de comercializare în cadrul societăţii, este considerată producător al acestuia şi răspunde în aceeaşi măsură ca şi producătorul;

4. orice altă persoană, care importă un produs din Uniunea Europeană în vederea vânzării, închirierii, cumpărării sau altei forme de înstrăinare în cadrul activităţii proprii de comercializare în cadrul societăţii, este considerată producător al acestuia şi răspunde în aceeaşi măsură ca şi producătorul;

5. dacă producătorul unui produs nu poate fi identificat, fiecare furnizor al produsului respectiv va fi tratat drept producător, dacă el nu comunică consumatorului prejudiciat, într-un interval de timp rezonabil, datele de identificare a producătorului sau a persoanei care i-a furnizat produsul; această dispoziţie este valabilă şi pentru un produs importat, în cazul în care produsul nu indică identitatea importatorului prevăzut la pct. 3 ori 4, chiar dacă este precizat numele producătorului.”

De remarcat este că se angajează răspunderea civilă a producătorului dacă persoana prejudiciată face dovada pagubei, a defectului și a raportului de cauzalitate dintre defect și pagubă (art. 6), dar, în cazul AI, așa cum am arătat mai sus, defectul nu este atât de facil de identificat decât prin raportare la un produs perfect (fără defecte). Mai mult decât atât, producătorul este exonerat de răspundere potrivit art. 7 din Legea nr. 240/2004 dacă nivelul cunoștințelor științifice și tehnice existent la momentul punerii în circulație a produsului nu i-a permis depistarea defectului în cauză sau, în funcție de împrejurări, defectul care a generat paguba nu a existat la data la care produsul a fost pus în circulație sau a apărut ulterior punerii în circulație a produsului, din cauze neimputabile lui.

B. Din perspectiva dreptului penal

Infracțiunea este fapta prevăzută de legea penală, săvârșită cu vinovăție, nejustificată și imputabilă persoanei care a săvârșit-o, iar infracțiunea este singurul temei al răspunderii penale, potrivit art. 15 C.pen. În plus, fapta constituie infracțiune numai dacă a fost săvârșită cu forma de vinovăție cerută de legea penală – art. 16 C.pen.

Astfel, în legislația penală operează principiul ”nulla poena sine culpa”, astfel, răspunderea este doar subiectivă. Răspunderea penală subiectivă este acea formă de răspundere care implică, pe lângă o manifestare umană de voință exterioară, existența vinovăției – mens rea, în una dintre formele sale (intenție, culpă, praeterintenție și alte forme derivate existente în tradiția juridică penală a unor state). Astfel, în momentul de față nu există nicio posibilitate de tragere la răspundere penală a producătorului sau a vânzătorului întrucât nu este reglementată posibilitatea răspunderii penale obiective. În acest sens, considerăm emergentă modificarea legislației penale pentru a oferi posibilitatea tragerii la răspundere a persoanelor pentru fapta altuia sau pentru lucruri.

De altfel, în doctrina penală s-a pus în discuție posibilitatea existenței unei forme de răspundere penală obiectivă, cum ar fi în cazul măsurilor de siguranță[viii], dar opinia majoritară este în sensul interpretării stricte a noțiunii și încă o abordare în sensul că legislația penală actuală este subsumată principiului răspunderii subiective, dar AI poate provoca o răsturnare a concepției tradiționaliste și o atenuare a acesteia. Chiar și în acest caz, înlăturarea completă a răspunderii penale a factorului uman ar crea o o altă problemă, în sensul că, în lipsa unei constrângeri legislative sub sancțiune penală, factorul uman ar putea dezvolta sisteme AI față de care erorile de programare, de ex., să nu poată fi imputate. Între cele două extreme, se află și problematica existenței a numeroși factori umani care pot influența modul în care sistemul AI funcționează și se dezvoltă, care complică și mai mult structura răspunderii.

În cauza C-326/88, Anklagemyndigheden c. Hansen & Soen I/S, C.J.C.E. a recunoscut pe cale jurisprudențială compatibilitatea cu dreptul comunitar a unei reglementări penale daneze care prevedea o responsabilitate penală obiectivă în sarcina unui patron pentru infracțiunile comise de unul din salariații săi. În concret, potrivit art. 9 din Ordinul Ministrului Muncii danez nr. 448 din 2 iunie 1981 în materie de transporturi, în cazul încălcării prevederilor din art. 7 (privind numărul maxim de ore în care șoferii transportatori pot conduce pe drumurile publice) sau art. 11 (cu referire la perioada de repaus zilnic obligatorie) din Regulamentul European nr. 543/69, angajatorul va putea răspunde penal dacă un transport este realizat în interesul său, chiar dacă infracțiunea nu îi poate fi imputată cu intenție sau din neglijență[ix].

De altfel, în doctrină penală română recentă[x] s-a dezvoltat ideea că AI poate fi subiect de drept, respectiv că ar putea răspunde din punct de vedere penal, propunându-se mai multe variante de abordare în acest sens, plecând de la modul în care s-au purtat discuțiile asupra capacității civile în cazul sclavilor, produsului de concepție, încetării capacității cu ocazia morții sau situația persoanelor aflate în comă, minorii, precum și persoanele juridice.

C. Din perspectiva eticii

Având în vedere că AI este un „produs viu”, în sensul că se adaptează și învață din datele nou obținute, există oricând posibilitatea ca produsul să evolueze, să nu mai corespundă „formei inițiale”, deși algoritmul nu este schimbat, și producătorul să fie exonerat de răspundere conform celor de mai sus. De asemenea, nivelul cunoștințelor științifice și tehnice se raportează la orice informație la care ar fi putut avea acces producătorul, dar tot victima este pusă în situația de a arăta că nivelul pe care îl reclamă producătorul nu este cel mai înalt nivel la care ar fi avut acces, acest lucru necesitând nu numai cunoștințe tehnice.

Prin urmare, este necesară regândirea întregii structuri a răspunderii în cazul AI, inclusiv prin identificarea criteriului pe care căruia riscul este analizat, fie pe criteriul unui risc la care este expus publicul larg, fie pe criteriul unui risc la care sunt supuse anumite categorii de drepturi.

Nu în ultimul rând, de foarte mult timp legislația nu a mai cunoscut o nevoie atât de mare de a fi abordată și într-o manieră filosofică. Dilemele morale impuse de sistemul AI nu sunt neapărat noi, dar, dacă până acum opțiunile pe care le aveam erau analizate din perspectiva posibilităților umane, ceea ce nu presupunea un calcul rece, matematic, al probabilităților, iată că ne vom afla în situația de a decide încă o dată asupra valorilor pe care le protejăm. Până acum, în cazul în care nu puteam evita provocarea altor pagube mai mari sau decese mai numeroase decât prin accidentarea unui alt autovehicul aflat în mers, având de ales într-o fracțiune de secundă între două mașini diferite, cu posibilitatea provocării morții oricăruia dintre șoferi, indiferent de opțiune, aceasta nu ne-ar fi fost imputabilă din punct de vedere moral. Cu toate acestea, în cazul unui sistem AI (vehicule autonome – VA), care, fiind conectat la o rețea de sisteme, „recunoaște” de la distanță că într-o mașină este o mamă tânără, avocat, cu copilul ei de 2 ani în spate, iar în cealaltă mașină este un bărbat în vârstă de 65 de ani, aflat la pensie, sau un inculpat recidivist cu șanse de 95% să fie condamnat din nou și alege în mod conștient să accidenteze una dintre mașini, apreciind asupra șanselor de supraviețuire ale șoferilor și pasagerilor sau asupra altor aspecte (vârstă, sex, studii, cazier etc.), atunci nu vom avea doar probleme de natură legală, dar și de natură morală. În acest caz, studiul eticii AI devine o chestiune imperios necesară în soluționarea dilemelor morale ale omenirii, iar interdisciplinaritatea devine laitmotivul dezvoltării AI.

Dacă privim omul ca pe un sistem, atunci noi acumulăm date din mediul înconjurător pe care le procesăm cu ajutorul acestui sistem, date ce sunt interpretate în baza percepției pe care o avem față de realitate, și care, la rândul lor, dau naștere la alte interpretări.

Conștiința este posibilitatea de a te autodefini în raport cu ceilalți, încadrați în timp și spațiu, iar în câmpul acesteia se situează chestiuni cum ar fi trăirile afective sau imaginația.

În cazul sociopaților este cunoscut faptul că aceștia nu au o conștiință dezvoltată, de aceea aceștia mimează reacțiile unei persoane într-o situație dată exact cum s-ar comporta un sistem AI, pe principiul IF-THIS-THEN-THAT (dacă mă aflu în situația X, atunci trebuie să am reacția Y).

Animalele nu au conștiință de sine, oamenii abia spre vârsta de 3 ani încep să se simtă ca subiecți distincți de ceilalți și își dezvoltă conștiința de sine la vârstă adultă, acesta fiind și motivul pentru care în legislație avem o lipsă a capacității de exercițiu, o capacitate de exercițiu restrânsă sau una deplină, într-o oarecare corelație cu posibilitatea de dezvoltare a unei conștiințe, respectiv a discernământului ca expresie a capacității intelectuale de a realiza că dacă acționezi într-un anumit fel (IF), rezultatul care se produce sau se poate produce este de un anumit fel (THEN).

Conștiința umană poate fi corelată din punctul de vedere al imposibilități de a înțelege resorturile care o animă cu black-box-ul sistemelor AI, deși există încă matematicieni, fizicieni, chimiști care încearcă să explice fenomenul:

„Desigur, nu știm exact care sunt condițiile suficiente pentru ca un sistem fizic să fie conștient, dar Tegmark a explorat deja patru condiții necesare pentru ca acest lucru să se întâmple. Pentru ca un sistem fizic să fie conștient, zice el, trebuie în primul rând ca acesta să stocheze informație, precum un computer și trebuie să fie capabil să proceseze informația, tot ca un computer. Dar, crede fizicianul, trebuie și să fie relativ independent de restul lumii, pentru că altfel această entitate nu ar simți că are niciun fel de existență proprie.

Și în final, așa cum susține și Giulio Tononi, sistemul ar trebui să fie integrat într-un întreg unificat, pentru a nu se diviza în părți independente. Tegmark chiar aduce în discuție aici un termen prin care își îmbracă viziunea – „perceptronium”, definit ca cea mai generală substanță care simte conștiință de sine subiectivă. Această substanță ar trebui să fie capabilă nu doar să stocheze și să proceseze informație, ci să facă aceste lucruri într-un mod care formează un întreg unificat și indivizibil.”[xi]

Creierul uman are numeroase erori de programare, pe care nu le-ar putea dezvolta sistemul AI, cum ar fi confabulația, situația în care omul își ignoră motivațiile adevărate și distorsionează realitatea pentru a explica anumite emoții, sistemul AI neavând trăiri pe care și le reprime, sau prejudecata retrospectivă, în care, din cauza ego-ului, analizăm trecutul și considerăm ca anumite lucruri chiar așa le-am perceput încă de la momentul T0, deși nu e adevărat. Considerăm că distinctivitatea dintre oameni si calculatoare, printre altele, se reduce la ”zona gri” care poate să intervină la un om, pe când, la calculatoare, totul e 1 sau 0, alb sau negru.

Dacă prezintă o variantă rece și calculată asupra realității, de ce ne temem, totuși, de AI? Dacă nu este vorba despre o simplă eroare de programare a sistemului sau de o intenție în a determina un calcul greșit, atunci putem întâlni și la sistemele tehnice una dintre capcanele inteligenței umane[xii], bias-ul sau prejudecata de confirmare, iar acest lucru este posibil prin prisma faptului că noi „hrănim” sistemul cu date și îi determinăm în mod indirect rezultatul. Dacă datele colectate de sistem nu sunt elocvente pentru a stabili un pattern, dacă datele sunt introduse în mod selectiv de către un operator uman sau dacă ele pot fi preluate în mod automat doar dintr-o anumită categorie, atunci apare bias-ul tehnic, care mai departe este în primul rând o sursă de discriminare, având consecințe extinse pe întregul lanț de drepturi ale omului.

În același timp, se vehiculează că, în curând, oamenii vor concura cu roboți pe piața locurilor de muncă. Conform specialiștilor, în 60 de ani inteligența artificială va constitui o amenințare serioasă pentru omenire. Până în 2022, similitudinea dintre robot și om, procesele de gândire vor fi egale cu aproximativ 10%, până în 2040 – 50%, iar în 2075 gândirea roboților nu vor putea fi diferențiate de cele ale unui om[xiii].

În prezent, China colectează masiv date cu caracter personal, punând la dispoziția populației o mulțime de aplicații și sisteme integrate, automatizate și independente de intervenția umană, în timp ce SUA, prin Președintele Donald Trump, care semnează un ordin la data de 11.02.2019[xiv], încearcă să își schimbe politica în sensul punerii domeniului AI în beneficiul statului, inclusiv prin finanțarea acestui sector, în încercarea de a menține SUA ca lider în domeniu. UE are politica de protecție a datelor cu caracter personal, aparent o frână legislativă în colectarea masivă de date, iar, cu ocazia Hotărârii CJUE din 16.07.2020 în Cauza C‑311/18[xv] prin care Curtea a decis să invalideze Decizia de punere în aplicare (UE) 2016/1250 a Comisiei din 12 iulie 2016 în temeiul Directivei 95/46/CE a Parlamentului European și a Consiliului privind caracterul adecvat al protecției oferite de Scutul de confidențialitate UE-SUA, adică invalidarea Privacy Shield, SUA este pusă să aleagă între concurența cu China și respectarea protecției datelor cu caracter personal, cel puțin față de cetățenii aflați sub protecția GDPR.

Lipsa „hranei”, adecvate calitativ și cantitativ, a sistemelor AI duce la o diminuare a potențialului de dezvoltare, dar în partea cealaltă a balanței se află însuși viitorul nostru, al omenirii. Folosindu-ne tot de o comparație, educația pe care un minor o primește pentru a-și dezvolta capacitatea de discernământ este similară datelor pe care noi le introducem într-un sistem pentru a da un rezultat valabil.

Pe de altă parte, dacă am merge în extrema cealaltă și nu am mai pune vreo piedică procesării de date cu caracter personal, atunci, deși, teoretic, rezultatele sistemului AI ar trebui sa fie corecte, dar ne-am expune altor pericole, o parte dintre ele fiind expuse într-un articol anterior[xvi].

Revenind la răspunderea în cazul unui sistem AI, cu ocazia participării în cadrul unui webinar organizat de Comisia Europeană la începutul lunii iunie[xvii], printre materialele puse la dispoziție s-au identificat și problemele puse în cadrul unei astfel de răspunderi civile, respectiv: Autonomia, manifestată prin dificultate de a crea legătura între rezultatul furnizat de AI și o decizie umană, dar și comportamentul AI care nu este mereu predictibil, nici măcar pentru dezvoltator, Opacitatea, manifestată prin existența acelui black-box, dificultatea omului de a înțelege mecanismul sistemului AI prin care ia decizii, dar și accesul imposibil al victimei prejudiciului la algoritm sau datele pe baza căruia s-a dezvoltat sistemul, și Complexitatea, adică faptul că AI este adesea integrat în ecosisteme IoT, precum și dificultatea de a identifica originea faptului vătămător.

D. Concluzie

Față de cele expuse în prezentul articol, considerăm că există o nevoie de înțelegere și de a asimilare a faptului că tehnologia face parte din cotidian și trebuie integrată și în legislația națională. În România, conform studiului DESI, mai puțin de o treime dintre persoanele cu vârsta cuprinsă între 16-74 ani au competențe cel puțin elementare. În ceea ce privește competențele digitale peste nivelul elementar, România se situează pe ultimul loc din UE, cu doar 10% dintre persoane.

Având în vedere că întreaga legislație trebuie regândită prin prisma unei noi paradigme dictată de insinuarea AI în viața noastră, dar și faptul că însuși Papa Francisc a recunoscut importanța principiilor etice în domeniul dezvoltării AI, semnând la data de 28.02.2020 prin intermediul The Pontifical Academy for Life, alături de Microsoft, IBM, FAO și guvernul italian documentul intitulat „Apelul Romei la o Etică AI” (the “Rome Call for an AI Ethics”[xviii]) prin care se dorește promovarea responsabilității în acest domeniu în cadrul organizațiilor, guvernelor și instituțiilor, considerăm că interdisciplinaritatea este cheia care va deschide orizontul unei noi ere a omenirii.

[i] One Hundred Year Study on Artificial Intelligence, https://ai100.stanford.edu/, accesat la data de 22.08.2020

[ii] Orientări în materie de etică pentru o inteligență artificială fiabilă elaborat de Grupul de Experți la nivel înalt privind AI (AI HLEG), elaborat în aprilie 2019 în cadrul Comisiei Europene

[iii] European Commission – White Paper On Artificial Intelligence – A European approach to excellence and trust, COM (2020), Brussels, 19.2.2020, https://ec.europa.eu/info/sites/info/files/commission-white-paper-artificial-intelligence-feb2020_en.pdf, accesat la data de 23.08.2020

[iv] Open Letter to the European Commission Artificial Intelligence And Robotics (2018), www.robotics-openletter.eu/, accesat în 22.08.2020

[v] R Abbott/A Sarch, ‘Punishing Artificial Intelligence: Legal Fiction or Science Fiction’, UC Davis Law Review, [forthcoming 2019, http://dx.doi.org/10.2139/ssrn.3327485], accesat la data de 22.08.2020

[vi] COM(2020) 64 final Raport privind implicațiile în materie de siguranță și răspundere ale inteligenței artificiale, ale internetului obiectelor și ale roboticii, elaborate de către Comisia Europeană,

[vii] Publicată în M.Of. Partea I, nr. 552 din 22 iunie 2004 ca o transpunere a Directivei nr. 85/374/CEE din 25 iulie 1985 privind răspunderea producătorului, publicată în Jurnalul Oficial al Comunităţilor Europene (JOCE) nr. L210 din 7 august 1985, modificată şi completată prin Directiva nr. 1.999/34/CE a Parlamentului European şi a Consiliului, publicată în Jurnalul Oficial al Comunităţilor Europene (JOCE), nr. L141 din 4 iunie 1999

[viii] Laura Maria Stănilă, Răspunderea penală obiectivă şi formele sale în dreptul penal român, URL: https://drept.uvt.ro/administrare/files/1481042436-laura-maria-stanila–.pdf, accesat la data de 22.08.2020

[ix] Al. Matache, Inaplicabilitatea principiului nulla poena sine culpa în dreptul penal european. Tendința spre răspunderea penală obiectivă, Revista Universul Juridic nr. 2/2018

[x] Laura Maria Stănilă, Inteligența artificială, dreptul penal și sistemul de justiție penală: amintiri din viitor, Edit. Universul Juridic, 2020

[xi] Conștiința – o stare de agregare a materiei, Alexandru Safta, 07.12.2016, URL: https://stiintasitehnica.com/constiinta-o-stare-de-agregare-materiei/, accesat la data de 22.08.2020

[xii] David McRaney, Capcanele inteligenței: învață cum să renunți la gândirea nesănătoasă, Edit. Globo, 2019

[xiii] Etzioni Oren, No, the Experts Don’t Think Superintelligent AI is a Threat to Humanity. URL: https://www.technologyreview.com/s/602410/no-the-experts-dont-think-superintelligent-aiis-a-threat-to-humanity, accesat la data de 22.08.2020

[xiv] URL: https://www.whitehouse.gov/presidential-actions/executive-order-maintaining-american-leadership-artificial-intelligence/, accesat la data de 22.08.2020

[xv]URL:http://curia.europa.eu/juris/document/document.jsf?text=&docid=228677&pageIndex=0&doclang=RO&mode=req&dir=&occ=first&part=1&cid=15600614, accesat la data de 22.08.2020

[xvi] Silvia Uscov, Dreptul la viață privată – de la drept la sursă de monetizare, URL: https://www.juridice.ro/680956/dreptul-la-viata-privata-de-la-drept-la-sursa-de-monetizare.html, accesat la data de 22.08.2020

[xvii] URL: https://ec.europa.eu/info/events/artificial-intelligence-who-should-be-liable-damage-2020-may-05_en, accesat la data de 22.08.2020

[xviii] Rome Call for AI Ethics, URL: http://www.academyforlife.va/content/dam/pav/documenti%20pdf/2020/CALL%2028%20febbraio/AI%20Rome%20Call%20x%20firma_DEF_DEF_.pdf, accesat la data de 22.08.2020